MiniMax于2025年6月17日正式开源了其革命性的MiniMax-M1模型,这款被誉为"全球首个开源大规模混合架构推理模型"的产品在多个方面刷新了行业标准。

核心技术突破

MiniMax-M1采用了创新的混合架构设计:

- 混合专家模型(MoE)与LightningAttention机制相结合

- 模型总参数量达到4560亿(456B)

- 单token激活参数为45.9B

- 原生支持1,000,000(1M)token的超长上下文输入

- 支持最高80,000token的输出长度

性能与成本优势

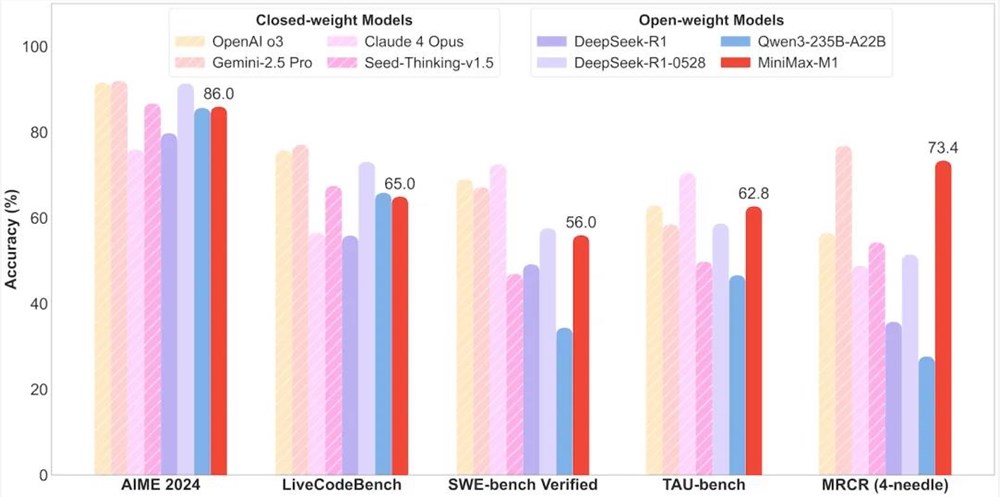

M1在多个关键指标上表现出色:

- 强化学习成本:仅53.74万美元(使用512块H800 GPU训练三周)

- 推理效率:8万token深度推理时仅需DeepSeek R1约30%的算力

- 长文本处理:上下文窗口是DeepSeek R1的8倍

- 工具使用能力:在TAU-bench测试中领先所有开源权重模型

商业应用价值

MiniMax-M1采用Apache 2.0许可证,企业可以:

- 无限制地用于商业应用

- 自由修改模型

- 无需支付授权费用

API服务方面,MiniMax也提供了具有竞争力的性价比,具体定价可参考其官方渠道。

行业影响

M1的发布标志着大模型技术进入"长上下文、低成本、高推理"的新阶段,其混合架构和高效训练方法(如CISPO算法)展示了通过技术创新突破"算力-资本"壁垒的可能性。在AIME2024测试集上,这一技术路线表现出色,收敛速度比传统方法快3-5倍。

开发者可通过以下渠道获取模型:

© 版权声明

文章收集自互联网,如有侵权,请联系删除